Facebook 又出 bug?怎么做才能少踩雷?

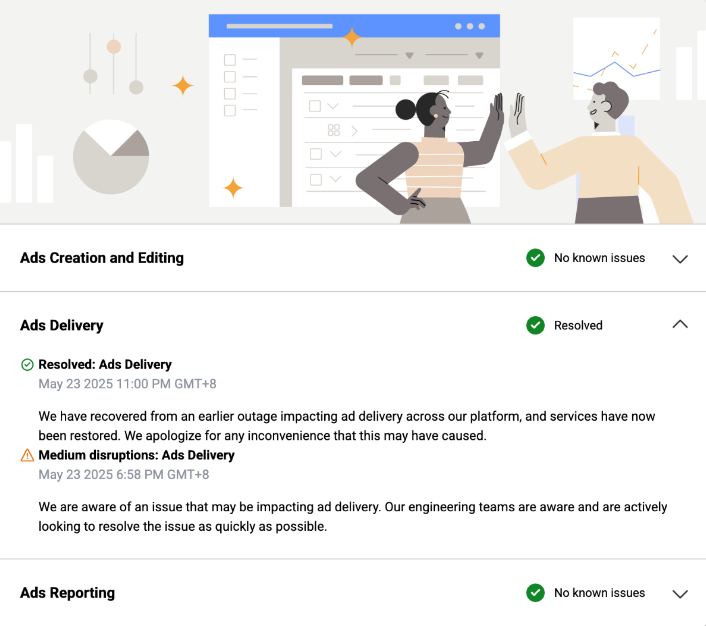

5月22日深夜,Facebook 又双叒出问题了。

广告组失控烧钱、预算秒清空、转化数据直接归零……等到 Meta 发公告说“已修复”,已经是8小时后了。

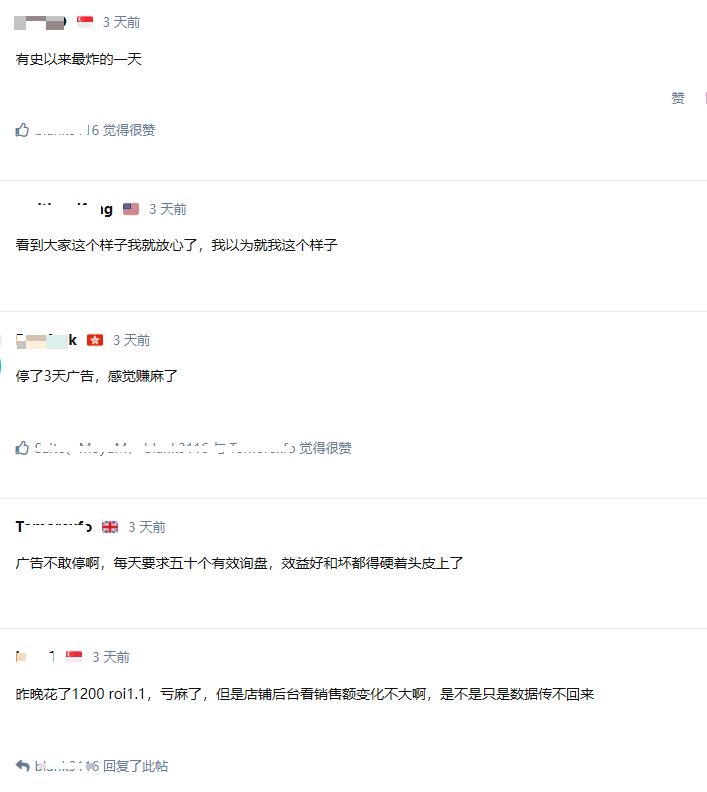

这一夜,有人凌晨四点还在群里发消息,有人早上醒来就发现预算炸穿,有人投放10小时却一单没出。

你以为是个别问题?不,整个跨境圈都在炸群。

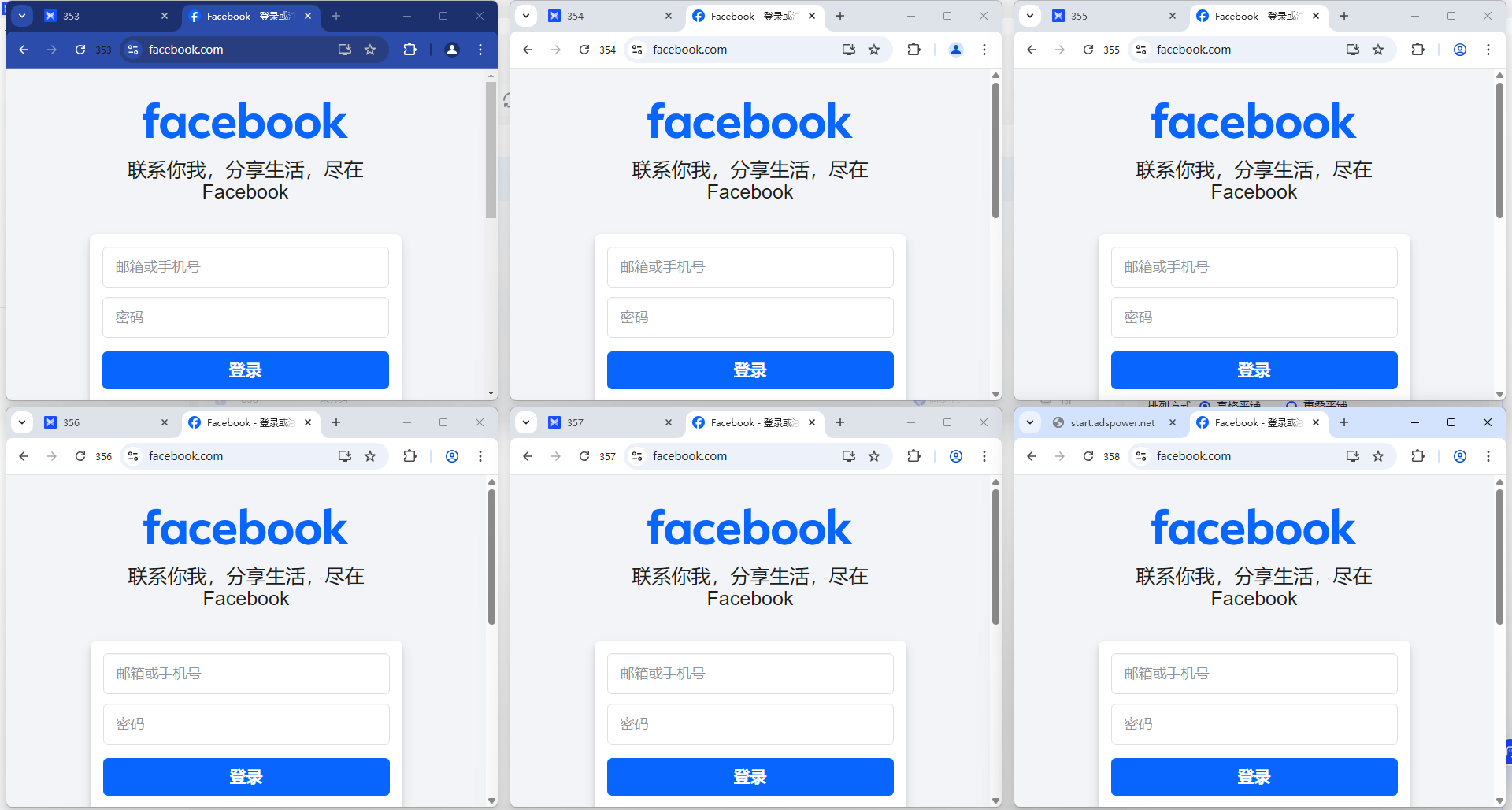

(来自 VeryFB 论坛)

面对突发 bug,环境能不能先稳住?

这种系统级的异常,我们控制不了也无法预警。但有没有什么办法,能提前打好“防护网”,在出事时减轻损失?

我们整理了业内一些常见做法,尤其适用于频繁跑 Facebook 的团队,也许能帮你多一层保障:

✅ 用指纹浏览器 + 独享固定 IP,账号更稳不易崩

最近 Facebook 的后台风控策略一直在调整,登录机制变得越来越敏感。

如果账号使用的是共享 IP 或不稳定环境,往往容易遇到这些问题:

-频繁弹出验证

-无法接收主页 / 授权失败

-长时间无法修改绑定信息

-频繁掉线 / 风控弹窗不断

建议使用指纹浏览器,搭配独享的固定 IP,这样能模拟真实用户行为,大大降低风控概率。

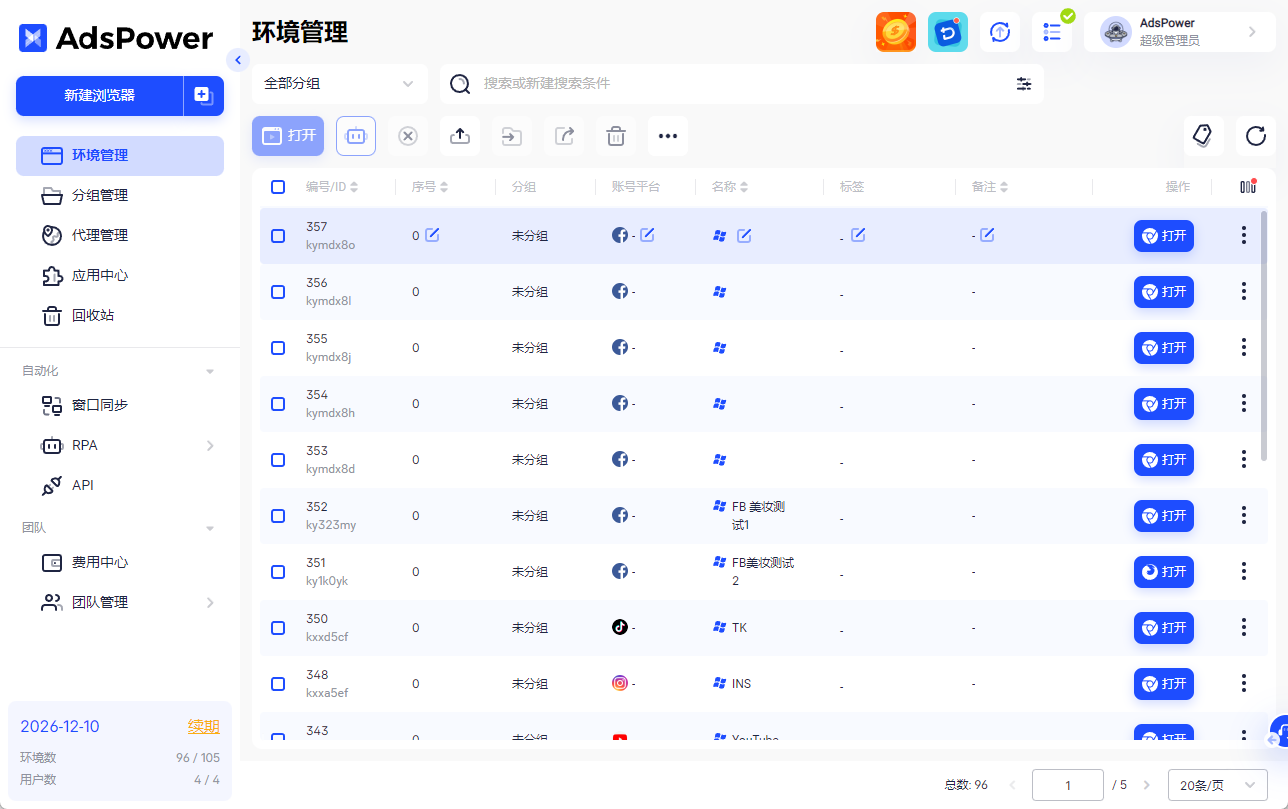

✅ 多账号隔离,避免问题连锁反应

如果你是团队化投放,一个账号“中招”可能会牵连整批账号。因此,账号环境的物理隔离非常关键。

像 AdsPower 这类指纹浏览器,会为每个账号创建独立浏览器环境,就像每个号都有“专属单间”,彼此之间完全隔离,不容易被一锅端。

✅ 支持批量控制,紧急情况止损更及时

这次 Facebook 异常时,不少广告组是“秒烧预算”,根本来不及逐个操作。

如果使用支持批量控制的工具,比如 AdsPower,可以实现批量暂停广告、同步操作多个账号、快速切换页面与执行指令,关键时刻几秒钟就能反应,比手动逐个处理更能抢时间、保预算。

写在最后

广告人每天都在和各种不确定性打交道,而平台级的 bug,只是最突出的一个。

我们能做的,是把底层投放环境尽可能搭建得更稳一些,提前准备好应对突发的方案。

广告投放这件事,不只是投放技巧和创意,还有很多不显眼但重要的细节——希望这些建议,能在下次系统出问题时,帮你多保住一点预算、少焦虑一点点。

延伸阅读

人们还读过

- 2026最新亚马逊 Audible 有声书推广赚钱全攻略,小白从0到1赚佣金指南

2026最新亚马逊 Audible 有声书推广赚钱全攻略,小白从0到1赚佣金指南

2026最新亚马逊有声书赚钱指南,手把手教你做 Audible 有声书推广,从注册到拿佣金全流程拆解,小白也能快速上手。

- 油管大量封杀疑似 AI 账号?如何打造“长期活跃”的高质量账号

油管大量封杀疑似 AI 账号?如何打造“长期活跃”的高质量账号

面对油管账号被封潮,本文从油管账号运营与油管养号角度,给出跨境电商多账号的合规模式与实操,并示范如何用AdsPower做可审计的多账号运维,显著降低封禁风险并提供下载指导。

- 什么工具可以用来多开账号?深度盘点多开账号工具大合集!

什么工具可以用来多开账号?深度盘点多开账号工具大合集!

想要实现多账号运营却担心关联封号?本文深度盘点2026年主流多开账号工具,从手机应用分身、模拟器到VPS及专业指纹浏览器。为您深度解析AdsPower如何通过内核级指纹伪装,保障跨境电商与社交媒体多账号安全,助力业务高效增长!

- X/推特流量变现:一文讲清楚如何用账号矩阵做选品测试

X/推特流量变现:一文讲清楚如何用账号矩阵做选品测试

本文面向有多账号资源的跨境运营者,详解如何用X/推特账号矩阵把控成本做选品测试、提高账号流量与转化,并介绍 AdsPower 指纹浏览器在防关联与多账号管理中的实操价值与功能。

- 普通人如何在 Facebook 赚钱?2026 年最新7种变现路径

普通人如何在 Facebook 赚钱?2026 年最新7种变现路径

2026年普通人如何在 Facebook 赚钱?本文整理7种可落地的网上赚钱路径,包含广告分成、电商带货、社群变现等实操方法,新手也能上手。